Vecteurs et matrices |

|

Motivation

Il est courant en recherche et en filtrage d’informations d’utiliser des vecteurs et des matrices. Nous procéderons donc à un rappel de quelques notions sur le sujet. Il est possible que vous ne soyez pas familier avec certains concepts plus avancés comme la décomposition en valeurs singulières : il ne sera pas nécessaire, dans ce cours, de faire des calculs matriciels sophistiqués, surtout qu’il est plus pratique d’utiliser des algorithmes informatiques pour réaliser ces opérations, mais vous devez en comprendre les concepts.

Je vous invite à lire le présent texte avec attention, à faire le travail d’autoévaluation de la semaine et à revenir périodiquement à cette page lorsque vous en sentirez le besoin.

Note : Si vous ne vous sentez pas capable de faire ces activités mathématiques, nous vous recommandons de vous inscrire au cours de mise à niveau MAT 1000 ou tout autre cours comparable, avant de suivre le présent cours.

Ensemble

L’ensemble des nombres réels, incluant les nombres à virgule flottante, est noté ![]() alors que l’ensemble des entiers est noté

alors que l’ensemble des entiers est noté ![]() . Les décimales peuvent être notées à l’anglaise avec un point comme dans cet exemple :

. Les décimales peuvent être notées à l’anglaise avec un point comme dans cet exemple : ![]() .

.

Valeur absolue

Étant donné ![]() ou

ou ![]() , alors

, alors ![]() si

si ![]() et

et ![]() si

si ![]() .

.

Nombres complexes

Dans le cadre de ce cours, nous éviterons de traiter les nombres complexes. Nous rappelons tout de même leur notation : si ![]() est un nombre complexe satisfaisant

est un nombre complexe satisfaisant ![]() où

où ![]() , alors

, alors ![]() .

.

Vecteur

Qu’est-ce qu’un vecteur ? À toutes fins utiles, en informatique, un vecteur est un tableau à une dimension comme dans cet exemple :

On dit que ce vecteur a 3 composantes. En mathématiques, on note ![]() la

la ![]() composante du vecteur

composante du vecteur ![]() . Dans notre exemple,

. Dans notre exemple, ![]() .

.

En informatique, un vecteur peut contenir des entiers, des booléens, etc. En Java, on peut définir un vecteur comme ceci :

float[] v = {1, 3, 5};ou

float[] v = new float[3];

v[0] = 1;

v[1] = 3;

v[2] = 5.Pour obtenir plus de détails et voir le point de vue des mathématiciens et des physiciens, je vous invite à visiter la page consacrée aux vecteurs dans l’encyclopédie Wikipédia.

Addition de vecteurs et de scalaires

Par convention, si on additionne un vecteur et un scalaire, le scalaire est ajouté à toutes les composantes du vecteur. Avec cet exemple,

nous avons

Matrice

En informatique, une matrice est un tableau à deux dimensions ayant ![]() rangées et

rangées et ![]() colonnes comme dans cet exemple :

colonnes comme dans cet exemple :

En mathématiques, on note ![]() la valeur se situant à la

la valeur se situant à la ![]() rangée et à la

rangée et à la ![]() colonne de la matrice

colonne de la matrice ![]() . Dans l’exemple précédent,

. Dans l’exemple précédent, ![]() vaut 2 alors que

vaut 2 alors que ![]() vaut 3. Une matrice peut contenir des entiers, des nombres réels, des booléens, etc.

vaut 3. Une matrice peut contenir des entiers, des nombres réels, des booléens, etc.

En Java, on peut définir une matrice comme ceci :

float[][] m = new float[3][2];

m[0][0] = 1; m[0][1] = 3;

m[1][0] = 2; m[1][1] = 5;

m[2][0] = 1; m[2][1] = 5;Wikipedia présente une discussion plus élaborée sur ce qu’est une matrice.

Multiplication d’un vecteur ou d’une matrice par un scalaire

Dans le cas où les composantes d’un vecteur ou d’une matrice sont des entiers ou des nombres réels (un « scalaire »), on peut multiplier respectivement le vecteur ou la matrice par un entier ou un nombre réel. La multiplication s’applique alors à chaque composante comme dans cet exemple :

Multiplication de vecteurs et de matrices

Étant donné une matrice ![]() ayant

ayant ![]() rangées et

rangées et ![]() colonnes et un vecteur

colonnes et un vecteur ![]() ayant

ayant ![]() composantes, la multiplication de

composantes, la multiplication de ![]() et de

et de ![]() , notée

, notée ![]() , est un vecteur

, est un vecteur ![]() ayant

ayant ![]() composantes et défini comme :

composantes et défini comme :

Voici un exemple :

En Java, on calcule la multiplication de deux vecteurs ainsi :

float[][] m = new float[3][2];

m[0][0] = 1; m[0][1] = 3;

m[1][0] = 2; m[1][1] = 5;

m[2][0] = 1; m[2][2] = 5;

float[] v = {1, 3};

// on va maintenant multiplier m et v

float[] r = new float[3];

for(int i = ; i < r.length; ++i)

for(int k = ; k < v.length; ++k)

r[i] += m[i][k]*v[k];

// c'est tout!Il faut un total de ![]() opérations pour multiplier une matrice et un vecteur, c’est-à-dire que le temps de calcul est approximativement proportionnel à la taille de la matrice. Il faudra donc 100 fois plus de temps pour multiplier une matrice

opérations pour multiplier une matrice et un vecteur, c’est-à-dire que le temps de calcul est approximativement proportionnel à la taille de la matrice. Il faudra donc 100 fois plus de temps pour multiplier une matrice ![]() avec un vecteur que pour multiplier une matrice

avec un vecteur que pour multiplier une matrice ![]() avec un vecteur.

avec un vecteur.

Multiplication de matrices avec d’autres matrices

Étant donné une matrice ![]() ayant

ayant ![]() rangées et

rangées et ![]() colonnes et une autre matrice

colonnes et une autre matrice ![]() ayant

ayant ![]() rangées et

rangées et ![]() colonnes, la multiplication de

colonnes, la multiplication de ![]() et de

et de ![]() , notée

, notée ![]() , est un vecteur

, est un vecteur ![]() ayant

ayant ![]() rangées et

rangées et ![]() colonnes et défini comme :

colonnes et défini comme :

Voici un exemple :

On peut voir la multiplication d’une matrice et d’un vecteur comme un cas particulier de la multiplication d’une matrice par une matrice dans le sens où un vecteur est une matrice ayant une seule colonne.

La transposée d’une matrice

La transposée d’une matrice ![]() , notée

, notée ![]() , est tout simplement une réécriture de la matrice où les colonnes deviennent des rangées et vice versa :

, est tout simplement une réécriture de la matrice où les colonnes deviennent des rangées et vice versa : ![]() . On peut montrer que

. On peut montrer que ![]() .

.

La transposée est une opération inversible, car la transposée de la transposée d’une matrice est la matrice elle-même : ![]() .

.

Formule. Étant donné deux matrices ![]() et

et ![]() , alors

, alors ![]() .

.

Matrice symétrique

Une matrice est symétrique si ![]() . En particulier, pour n’importe quelle matrice

. En particulier, pour n’importe quelle matrice ![]() , la matrice

, la matrice ![]() est symétrique puisque

est symétrique puisque ![]() .

.

Matrice normale

Une matrice carrée est dite normale si elle commute avec sa transposée : ![]() . Par exemple, cette matrice n’est pas normale [1] :

. Par exemple, cette matrice n’est pas normale [1] :

En effet, nous avons

et aussi

Par contre, la matrice suivante est normale :

En effet, il suffit de vérifier que dans ce cas particulier, ![]() et donc,

et donc, ![]() .

.

Une matrice symétrique est automatiquement normale puisque ![]() .

.

Matrice diagonale et identité

Une matrice carrée est diagonale si seules les composantes sur la diagonale sont différentes de zéro : ![]() lorsque

lorsque ![]() .

.

Une matrice diagonale est égale à sa transposée : ![]() . Une matrice diagonale est nécessairement normale.

. Une matrice diagonale est nécessairement normale.

Cette matrice est diagonale :

Lorsque la matrice est diagonale et que toutes les valeurs différentes de zéro sont unitaires, on dit qu’il s’agit d’un matrice identité (notée ![]() ).

).

La matrice suivante est une matrice identité :

La multiplication d’une matrice par la matrice identité la laisse inchangée : ![]() .

.

Matrice inverse

Si ![]() et

et ![]() sont deux matrices carrées satisfaisant

sont deux matrices carrées satisfaisant ![]() , alors

, alors ![]() ; on dit que les matrices sont inverses l’une de l’autre et on note

; on dit que les matrices sont inverses l’une de l’autre et on note ![]() ainsi que

ainsi que ![]() . Toutes les matrices n’ont pas un inverse. Vous n’aurez pas à calculer l’inverse d’une matrice dans ce cours.

. Toutes les matrices n’ont pas un inverse. Vous n’aurez pas à calculer l’inverse d’une matrice dans ce cours.

Vous pouvez vérifier que

La matrice suivante n’a pas d’inverse :

Formule. Étant donné deux matrices inversibles ![]() et

et ![]() , alors

, alors ![]() .

.

Une matrice qui n’est pas carrée peut néanmoins avoir un inverse par la gauche ou par la droite : si ![]() n’est pas carrée, il peut exister

n’est pas carrée, il peut exister ![]()

tel que ![]() ou

ou ![]() (mais pas les deux). Voici un exemple :

(mais pas les deux). Voici un exemple :

On utilise souvent la matrice inverse pour résoudre des équations linéaires. Ainsi, étant donné un matrice ![]() et un vecteur

et un vecteur ![]() , si on a

, si on a ![]() , alors

, alors ![]() . Cependant, il est possible que le problème

. Cependant, il est possible que le problème ![]() ait une solution même si

ait une solution même si ![]() n’est pas inversible comme dans cet exemple :

n’est pas inversible comme dans cet exemple :

(Une solution possible est : ![x =

\left [ \begin{array}{c}

1 \\

0 \\

\end{array}\right ]

x =

\left [ \begin{array}{c}

1 \\

0 \\

\end{array}\right ]](local/cache-TeX/d0bc4a21c9a82b55f2a032b8d46d16d7.png) .)

.)

Toutes les matrices, mêmes les matrices qui ne sont pas carrées ou qui n’ont pas d’inverse, ont une matrice pseudo-inverse qui permet de trouver la meilleure solution (au sens des moindres carrés) pour l’équation ![]() . On peut calculer la matrice pseudo-inverse en utilisant la décomposition en valeurs singulières (voir le texte plus bas).

. On peut calculer la matrice pseudo-inverse en utilisant la décomposition en valeurs singulières (voir le texte plus bas).

Ainsi, la matrice pseudo-inverse de

est tout simplement

Pour résoudre l’équation ![\left [ \begin{array}{cc}

2 & 0 \\

0 & 0 \\

\end{array}\right ] x= \left [ \begin{array}{c}

1 \\

0 \\

\end{array}\right ] \left [ \begin{array}{cc}

2 & 0 \\

0 & 0 \\

\end{array}\right ] x= \left [ \begin{array}{c}

1 \\

0 \\

\end{array}\right ]](local/cache-TeX/66d27abdcb664e046a1215fd4744af13.png) , il suffit de calculer :

, il suffit de calculer :

Norme

La norme d’un vecteur ou d’une matrice ![]() est « une mesure de longueur » notée

est « une mesure de longueur » notée ![]() ayant les propriétés suivantes :

ayant les propriétés suivantes :

– La norme est toujours positive : ![]() .

.

– La norme est proportionnelle : ![]() lorsque

lorsque ![]() est un scalaire.

est un scalaire.

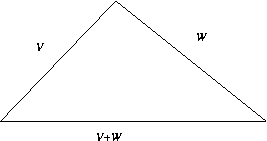

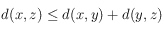

– La norme respecte l’inégalité du triangle : ![]() .

.

En termes plus simples, on peut exprimer ces conditions comme ceci :

– la longueur d’un vecteur ne peut être négative ;

– si on multiplie les composantes d’un vecteur par ![]() , alors le vecteur est

, alors le vecteur est ![]() fois plus long ;

fois plus long ;

– si on dessine un triangle, alors la somme de deux des côtés d’un triangle doit être plus grande que l’autre côté.

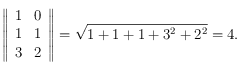

Norme euclidienne et norme de Frobenius

La norme euclidienne est tout simplement la racine carrée de la somme des composantes au carré : ![]() . Étant donné un vecteur

. Étant donné un vecteur ![]() , la norme est

, la norme est ![]() . À moins de mention contraire, nous utilisons toujours la norme euclidienne.

. À moins de mention contraire, nous utilisons toujours la norme euclidienne.

En Java, on peut calculer la norme euclidienne d’un vecteur comme ceci :

float[] v = new float[3];

v[0] = 1;

v[1] = 3;

v[2] = 5;

float norme = .0f;

for(int k = ; k < v.length; ++k) norme += v[k]*v[k];

return Math.sqrt(norme);Dans le cas d’une matrice, la norme euclidienne prend le nom de la norme de Frobenius :

Voici un exemple :

La norme de Frobenius est sous-multiplicative, c’est-à-dire que

et cette relation s’applique que ![]() soit une matrice ou un vecteur.

soit une matrice ou un vecteur.

Produit scalaire

Le produit scalaire entre deux vecteurs est la somme du produit de leurs composantes une à une :

Pour pouvoir calculer le produit scalaire de deux vecteurs, il faut qu’ils aient le même nombre de composantes.

Voici un exemple :

On peut calculer le produit scalaire en Java avec le code suivant :

float[] v = new float[3];

float[] w = new float[3];

v[0] = 1; w[0] = 1;

v[1] = 3; w[1] = 3;

v[2] = 5; w[2] = 2;

float produit = .0f;

assert v.length == w.length;

for(int k = ; k < v.length; ++k) produit += v[k]*w[k];Voici un script JavaScript qui calcule le produit scalaire :

V2:

On peut vérifier que ![]() . De plus, le vecteur

. De plus, le vecteur ![]() est unitaire, c’est-à-dire qu’il a une norme de 1 :

est unitaire, c’est-à-dire qu’il a une norme de 1 :  .

.

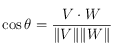

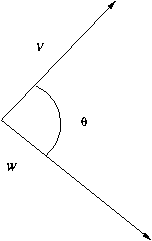

Le cosinus entre deux vecteurs est donné par :

.

.

Le script suivant calcule le cosinus entre deux vecteurs :

V2:

Vecteurs orthogonaux

Les vecteurs ![]() ,

, ![]() et

et ![]() sont orthogonaux si le produit scalaire entre les vecteurs est nul :

sont orthogonaux si le produit scalaire entre les vecteurs est nul : ![]() ,

, ![]() et

et ![]() . On dit qu’ils sont orthonormaux si en plus d’être orthogonaux, leur norme est unitaire :

. On dit qu’ils sont orthonormaux si en plus d’être orthogonaux, leur norme est unitaire : ![]() ,

, ![]() et

et ![]() .

.

Par exemple, les vecteurs suivants sont orthogonaux :

alors que les vecteurs suivants sont orthonormaux :

Matrice diagonalisable

Une matrice carrée ![]() est diagonalisable s’il existe une matrice inversible

est diagonalisable s’il existe une matrice inversible ![]() telle que

telle que ![]() est une matrice diagonale. Toutes les matrices normales sont diagonalisables, mais toutes les matrices ne sont pas diagonalisables. Les valeurs trouvées sur la diagonale sont appelées les valeurs propres de la matrice et sont toujours les mêmes, même si le choix de

est une matrice diagonale. Toutes les matrices normales sont diagonalisables, mais toutes les matrices ne sont pas diagonalisables. Les valeurs trouvées sur la diagonale sont appelées les valeurs propres de la matrice et sont toujours les mêmes, même si le choix de ![]() n’est pas toujours unique. Vous n’aurez pas à diagonaliser des matrices dans ce cours.

n’est pas toujours unique. Vous n’aurez pas à diagonaliser des matrices dans ce cours.

Un vecteur propre est un vecteur ![]() tel que

tel que ![]() où

où ![]() est un scalaire appelé valeur propre.

est un scalaire appelé valeur propre.

Si ![]() est une matrice diagonalisable

est une matrice diagonalisable ![]() , alors il existe

, alors il existe ![]() vecteurs propres orthogonaux dont les valeurs propres correspondent aux valeurs sur la diagonale de

vecteurs propres orthogonaux dont les valeurs propres correspondent aux valeurs sur la diagonale de ![]() .

.

Note : une définition équivalente dit qu’une matrice carrée ![]() est diagonalisable s’il existe une matrice inversible

est diagonalisable s’il existe une matrice inversible ![]() telle que

telle que ![]() est une matrice diagonale.

est une matrice diagonale.

Métrique

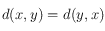

Une métrique est une mesure de distance entre deux points satisfaisant les conditions suivantes :

-

(une distance ne peut être négative) ;

(une distance ne peut être négative) ; -

si et seulement si

si et seulement si  (si la distance est nulle, c’est que les deux points sont au même endroit) ;

(si la distance est nulle, c’est que les deux points sont au même endroit) ; -

(la distance de x à y est la même que la distance de y à x) ;

(la distance de x à y est la même que la distance de y à x) ; -

(inégalité du triangle).

(inégalité du triangle).

Étant donné une norme, on peut définir une métrique comme suit ![]() .

.

Exemple 1. La distance euclidienne entre deux vecteurs ![]() est définie par le produit scalaire :

est définie par le produit scalaire : ![]() .

.

Exemple 2. L’angle entre deux vecteurs n’est pas une métrique.

Exemple 3. La distance de Hamming est un exemple de métrique. On définit la distance de Hamming entre deux chaînes de caractères de même longueur comme étant le nombre de caractères qui sont différents. Par exemple, la distance de Hamming entre « 123cb » et « 133cc » est 2.

Matrice orthonormale

Les colonnes d’une matrice peuvent être vues comme des vecteurs. Si l’ensemble de tous ces vecteurs sont orthonormaux, alors la matrice est orthonormale [2]. Une matrice orthonormale satisfait ![]() , c’est-à-dire

, c’est-à-dire

que sa transposée est son inverse par la droite. Une matrice orthonormale n’est pas nécessairement carrée.

Cette matrice est orthonormale :

Attention de ne pas confondre les matrices orthonormales avec les matrices normales ! Par exemple, une matrice qui n’est pas carrée ne peut être normale, mais elle peut être orthonormale. La matrice suivante est normale, mais pas orthonormale :

Par contre, une matrice carrée orthonormale est nécessairement normale.

Décomposition en valeurs singulières

Toutes les matrices ![]() peuvent s’écrire sous la forme

peuvent s’écrire sous la forme ![]() où

où ![]() et

et ![]() sont orthonormales et

sont orthonormales et ![]() est une matrice diagonale [3]. Pour les fins de ce cours, vous avez seulement besoin de savoir que toutes les matrices ont une décomposition en valeurs singulières. Vous n’aurez pas à calculer la décomposition en valeurs singulières d’une matrice dans ce cours ; il existe d’ailleurs des librairies logicielles bien au point pour le faire à votre place si le besoin se présente.

est une matrice diagonale [3]. Pour les fins de ce cours, vous avez seulement besoin de savoir que toutes les matrices ont une décomposition en valeurs singulières. Vous n’aurez pas à calculer la décomposition en valeurs singulières d’une matrice dans ce cours ; il existe d’ailleurs des librairies logicielles bien au point pour le faire à votre place si le besoin se présente.

L’intérêt de la décomposition en valeurs singulières est de pouvoir manipuler une matrice diagonale au lieu de la matrice originale. Cette technique mathématique est à la base d’un modèle en recherche d’information appelé Latent Semantic Indexing.

On peut aussi utiliser la décomposition en valeurs singulières pour calculer la pseudo-inverse d’une matrice. En effet, si on a la décomposition ![]() où

où ![]() est une matrice diagonale ayant les valeurs

est une matrice diagonale ayant les valeurs ![]() sur la diagonale, alors la pseudo-inverse de

sur la diagonale, alors la pseudo-inverse de ![]() est donnée par

est donnée par ![]() où

où ![]() est la matrice diagonale ayant les valeurs

est la matrice diagonale ayant les valeurs ![]() sur la diagonale avec la convention

sur la diagonale avec la convention ![]() .

.

Le cas des matrices déjà diagonales est très simple. La décomposition en valeurs singulières de la matrice

est tout simplement

et la matrice pseudo-inverse est

Lecture suggérée : Décomposition en valeurs singulières

(wikipédia)

JAMA

Il existe de nombreuses librairies, en Java et dans tous les autres langages, pour faire toutes les opérations que nous avons décrites sur les vecteurs et matrices. Certaines de ces opérations sont plus difficiles, comme l’inversion d’une matrice ou sa décomposition en valeurs singulières. La librairie Java « JAMA » est une librairie du domaine public qui permet de faire ces opérations et plusieurs autres. Vous pouvez librement l’utiliser dans vos programmes Java.

Références

– Les articles matrice et vecteur dans l’encyclopédie Wikipédia contiennent de l’information et des exemples supplémentaires.

[1] On peut toujours vérifier facilement si une matrice est normale en faisant la multiplication des matrices.

[2] Certains auteurs appellent de telles matrices des matrices

orthogonales, mais d’autres réservent cette appellation aux matrices carrées. D’autres auteurs, encore, exigent que les rangées de la matrice, plutôt que les colonnes, soient des vecteurs orthogonaux.

[3] L’énoncé exact de la définition peut varier d’un auteur à l’autre, mais toutes les définitions devraient être équivalentes.

![V = \left [ \begin{array}{c}1 \\ 2 \\ 1\end{array} \right ]. V = \left [ \begin{array}{c}1 \\ 2 \\ 1\end{array} \right ].](local/cache-TeX/41371d918c279bef57673b3b7fd0a04f.png)

![V = \left [ \begin{array}{c}1 \\ 2 \\ 1\end{array} \right ], V = \left [ \begin{array}{c}1 \\ 2 \\ 1\end{array} \right ],](local/cache-TeX/960e97a794f92e8c8647bf7824b4980a.png)

![V-1 = V+ (-1)= \left [ \begin{array}{c}0 \\ 1 \\ 0\end{array} \right ]. V-1 = V+ (-1)= \left [ \begin{array}{c}0 \\ 1 \\ 0\end{array} \right ].](local/cache-TeX/50d3f9db95ec87f3a05fabaa2367c92f.png)

![\left [ \begin{array}{cc}1 & 3 \\ 2 & 5 \\ 1 & 5\end{array} \right ]. \left [ \begin{array}{cc}1 & 3 \\ 2 & 5 \\ 1 & 5\end{array} \right ].](local/cache-TeX/76161fdf6d6034a54f938a2a98d4b6aa.png)

![2 \left [ \begin{array}{c}1 \\ 2 \\ 1\end{array} \right ] = \left [ \begin{array}{c}2 \\ 4 \\ 2\end{array} \right ]. 2 \left [ \begin{array}{c}1 \\ 2 \\ 1\end{array} \right ] = \left [ \begin{array}{c}2 \\ 4 \\ 2\end{array} \right ].](local/cache-TeX/1353e73b55c1cfd5f3c711ac0fac9ccb.png)

![\left [ \begin{array}{cc}

1 & 3\\

1 & 2 \\

3 & 1

\end{array}\right ] \left [ \begin{array}{c}

1 \\

1

\end{array}\right] =

\left [ \begin{array}{c}

4 \\

3 \\

4

\end{array}\right].

\left [ \begin{array}{cc}

1 & 3\\

1 & 2 \\

3 & 1

\end{array}\right ] \left [ \begin{array}{c}

1 \\

1

\end{array}\right] =

\left [ \begin{array}{c}

4 \\

3 \\

4

\end{array}\right].](local/cache-TeX/c22f5e2c91e2e5b2e6ca7b8a189e0294.png)

![\left [ \begin{array}{cc}

1 & 3\\

1 & 2 \\

3 & 1

\end{array}\right ] \left [ \begin{array}{cc}

1 & 1 \\

1 & 0

\end{array}\right] =

\left [ \begin{array}{cc}

4 & 1\\

3 & 1 \\

4 & 3

\end{array}\right].

\left [ \begin{array}{cc}

1 & 3\\

1 & 2 \\

3 & 1

\end{array}\right ] \left [ \begin{array}{cc}

1 & 1 \\

1 & 0

\end{array}\right] =

\left [ \begin{array}{cc}

4 & 1\\

3 & 1 \\

4 & 3

\end{array}\right].](local/cache-TeX/48d8d6bff4fb7b9eb4a38671d60dcccb.png)

![\left [ \begin{array}{cc}

1 & 3\\

1 & 2 \\

3 & 1

\end{array}\right ]^t = \left [ \begin{array}{ccc}

1 & 1 & 3\\

3 & 2 & 1

\end{array}\right].

\left [ \begin{array}{cc}

1 & 3\\

1 & 2 \\

3 & 1

\end{array}\right ]^t = \left [ \begin{array}{ccc}

1 & 1 & 3\\

3 & 2 & 1

\end{array}\right].](local/cache-TeX/5ddf1e36ffcda16d233d8dc900964242.png)

![\left [ \begin{array}{cc}

1 & 1 \\

0 & 2 \\

\end{array}\right ].

\left [ \begin{array}{cc}

1 & 1 \\

0 & 2 \\

\end{array}\right ].](local/cache-TeX/528fbe1c7c833e59176a9bb5fb41aac3.png)

![\left [ \begin{array}{cc}

1 & 1 \\

0 & 2 \\

\end{array}\right ]

\left [ \begin{array}{cc}

1 & 0 \\

1 & 2 \\

\end{array}\right ]

=

\left [ \begin{array}{cc}

2 & 2 \\

2 & 4 \\

\end{array}\right ]

\left [ \begin{array}{cc}

1 & 1 \\

0 & 2 \\

\end{array}\right ]

\left [ \begin{array}{cc}

1 & 0 \\

1 & 2 \\

\end{array}\right ]

=

\left [ \begin{array}{cc}

2 & 2 \\

2 & 4 \\

\end{array}\right ]](local/cache-TeX/e05d64a07ddff4afd4d4b9a4f10be4e5.png)

![\left [ \begin{array}{cc}

1 & 0 \\

1 & 2 \\

\end{array}\right ]

\left [ \begin{array}{cc}

1 & 1 \\

0 & 2 \\

\end{array}\right ]

=

\left [ \begin{array}{cc}

1 & 1 \\

1 & 5 \\

\end{array}\right ].

\left [ \begin{array}{cc}

1 & 0 \\

1 & 2 \\

\end{array}\right ]

\left [ \begin{array}{cc}

1 & 1 \\

0 & 2 \\

\end{array}\right ]

=

\left [ \begin{array}{cc}

1 & 1 \\

1 & 5 \\

\end{array}\right ].](local/cache-TeX/dda27a963dcc98196effe09329c11bc0.png)

![\left [ \begin{array}{cc}

1 & 2\\

2 & 3 \\

\end{array}\right ].

\left [ \begin{array}{cc}

1 & 2\\

2 & 3 \\

\end{array}\right ].](local/cache-TeX/28f096dbee7672a91d8a0f671433a74c.png)

![\left [ \begin{array}{ccc}

1 & 0 & 0\\

0 & 2 & 0\\

0 & 0 & 3

\end{array}\right ].

\left [ \begin{array}{ccc}

1 & 0 & 0\\

0 & 2 & 0\\

0 & 0 & 3

\end{array}\right ].](local/cache-TeX/b039e203e1cf6048fe82813fdf397b7e.png)

![\left [ \begin{array}{ccc}

1 & 0 & 0\\

0 & 1 & 0\\

0 & 0 & 1

\end{array}\right ].

\left [ \begin{array}{ccc}

1 & 0 & 0\\

0 & 1 & 0\\

0 & 0 & 1

\end{array}\right ].](local/cache-TeX/2261bb27351d6cf0b809510b41b0b820.png)

![\left [ \begin{array}{cc}

1 & 1 \\

0 & -1 \\

\end{array}\right ]^{-1}=

\left [ \begin{array}{cc}

1 & 1 \\

0 & -1 \\

\end{array}\right ].

\left [ \begin{array}{cc}

1 & 1 \\

0 & -1 \\

\end{array}\right ]^{-1}=

\left [ \begin{array}{cc}

1 & 1 \\

0 & -1 \\

\end{array}\right ].](local/cache-TeX/38b18f8a57b4109069b1d882becabd06.png)

![\left [ \begin{array}{cc}

1 & 0 \\

0 & 0 \\

\end{array}\right ].

\left [ \begin{array}{cc}

1 & 0 \\

0 & 0 \\

\end{array}\right ].](local/cache-TeX/a60a00eb27f03680e80690fe32e1a167.png)

![\left [ \begin{array}{ccc}

-2 & 3 & 0\\

1 & -1 & 0 \\

\end{array}\right]

\left [ \begin{array}{cc}

1 & 3\\

1 & 2 \\

3 & 1

\end{array}\right ] =

\left [ \begin{array}{cc}

1 & 0\\

0 & 1

\end{array}\right].

\left [ \begin{array}{ccc}

-2 & 3 & 0\\

1 & -1 & 0 \\

\end{array}\right]

\left [ \begin{array}{cc}

1 & 3\\

1 & 2 \\

3 & 1

\end{array}\right ] =

\left [ \begin{array}{cc}

1 & 0\\

0 & 1

\end{array}\right].](local/cache-TeX/e5f3b3cdfbe5966843dab3b84b73c441.png)

![\left [ \begin{array}{cc}

1 & 0 \\

0 & 0 \\

\end{array}\right ] x =

\left [ \begin{array}{c}

1 \\

0 \\

\end{array}\right ].

\left [ \begin{array}{cc}

1 & 0 \\

0 & 0 \\

\end{array}\right ] x =

\left [ \begin{array}{c}

1 \\

0 \\

\end{array}\right ].](local/cache-TeX/2e70fa9033a87299a61d8bf64e86de7f.png)

![A=\left [ \begin{array}{cc}

2 & 0 \\

0 & 0 \\

\end{array}\right ]

A=\left [ \begin{array}{cc}

2 & 0 \\

0 & 0 \\

\end{array}\right ]](local/cache-TeX/6dcd86c09809fcca5072b63b4d3b6386.png)

![\left [ \begin{array}{cc}

1/2 & 0 \\

0 & 0 \\

\end{array}\right ].

\left [ \begin{array}{cc}

1/2 & 0 \\

0 & 0 \\

\end{array}\right ].](local/cache-TeX/fe38079d930a60eb66bb97c2fcfd07c0.png)

![\left [ \begin{array}{cc}

1/2 & 0 \\

0 & 0 \\

\end{array}\right ]\left [ \begin{array}{c}

1 \\

0 \\

\end{array}\right ] =

\left [ \begin{array}{c}

1/2 \\

0 \\

\end{array}\right ].

\left [ \begin{array}{cc}

1/2 & 0 \\

0 & 0 \\

\end{array}\right ]\left [ \begin{array}{c}

1 \\

0 \\

\end{array}\right ] =

\left [ \begin{array}{c}

1/2 \\

0 \\

\end{array}\right ].](local/cache-TeX/1644da39ed6872c058cfa4f9d50a5d15.png)

![\left [ \begin{array}{c}

1 \\

1 \\

3

\end{array}\right ] \cdot \left [ \begin{array}{c}

1 \\

1 \\

1

\end{array}\right] = 5.

\left [ \begin{array}{c}

1 \\

1 \\

3

\end{array}\right ] \cdot \left [ \begin{array}{c}

1 \\

1 \\

1

\end{array}\right] = 5.](local/cache-TeX/5f40614862c7c858b6da4659c80f9af2.png)

![\left [ \begin{array}{c}

1 \\

0 \\

0

\end{array}\right ] , \left [ \begin{array}{c}

0 \\

1 \\

1

\end{array}\right] , \left [ \begin{array}{c}

0 \\

-1 \\

1

\end{array}\right],

\left [ \begin{array}{c}

1 \\

0 \\

0

\end{array}\right ] , \left [ \begin{array}{c}

0 \\

1 \\

1

\end{array}\right] , \left [ \begin{array}{c}

0 \\

-1 \\

1

\end{array}\right],](local/cache-TeX/0d061d1b5379a06226c1440d74bd5ba9.png)

![\left [ \begin{array}{c}

1 \\

0 \\

0

\end{array}\right ] , \left [ \begin{array}{c}

0 \\

1/\sqrt{2} \\

1/\sqrt{2}

\end{array}\right] , \left [ \begin{array}{c}

0 \\

-1/\sqrt{2} \\

1/\sqrt{2}

\end{array}\right].

\left [ \begin{array}{c}

1 \\

0 \\

0

\end{array}\right ] , \left [ \begin{array}{c}

0 \\

1/\sqrt{2} \\

1/\sqrt{2}

\end{array}\right] , \left [ \begin{array}{c}

0 \\

-1/\sqrt{2} \\

1/\sqrt{2}

\end{array}\right].](local/cache-TeX/4729f8169d36650717602325c04a6e86.png)

![\left [ \begin{array}{ccc}

1 & 0 & 0\\

0 & 1/\sqrt{2} & -1/\sqrt{2} \\

0 & 1/\sqrt{2} & 1/\sqrt{2}

\end{array}\right ].

\left [ \begin{array}{ccc}

1 & 0 & 0\\

0 & 1/\sqrt{2} & -1/\sqrt{2} \\

0 & 1/\sqrt{2} & 1/\sqrt{2}

\end{array}\right ].](local/cache-TeX/a3adc245bf92f63b274a426ab4b48b53.png)

![\left [ \begin{array}{cc}

1 & 1\\

1 & 1

\end{array}\right ].

\left [ \begin{array}{cc}

1 & 1\\

1 & 1

\end{array}\right ].](local/cache-TeX/d936ea159136e4cace0f8da8d2679dcc.png)

![\left [ \begin{array}{cc}

2 & 0 \\

0 & 3 \\

\end{array}\right ] \left [ \begin{array}{cc}

2 & 0 \\

0 & 3 \\

\end{array}\right ]](local/cache-TeX/d14d2fd45614ce42870901c4100fbc91.png)

![\left [ \begin{array}{cc}

1 & 0 \\

0 & 1 \\

\end{array}\right ]

\left [ \begin{array}{cc}

2 & 0 \\

0 & 3 \\

\end{array}\right ]

\left [ \begin{array}{cc}

1 & 0 \\

0 & 1 \\

\end{array}\right ]

\left [ \begin{array}{cc}

1 & 0 \\

0 & 1 \\

\end{array}\right ]

\left [ \begin{array}{cc}

2 & 0 \\

0 & 3 \\

\end{array}\right ]

\left [ \begin{array}{cc}

1 & 0 \\

0 & 1 \\

\end{array}\right ]](local/cache-TeX/292bbcce1c628cf516b19f69641945db.png)

![\left [ \begin{array}{cc}

1 & 0 \\

0 & 1 \\

\end{array}\right ]

\left [ \begin{array}{cc}

1/2 & 0 \\

0 & 1/3 \\

\end{array}\right ]

\left [ \begin{array}{cc}

1 & 0 \\

0 & 1 \\

\end{array}\right ]=\left [ \begin{array}{cc}

1/2 & 0 \\

0 & 1/3 \\

\end{array}\right ].

\left [ \begin{array}{cc}

1 & 0 \\

0 & 1 \\

\end{array}\right ]

\left [ \begin{array}{cc}

1/2 & 0 \\

0 & 1/3 \\

\end{array}\right ]

\left [ \begin{array}{cc}

1 & 0 \\

0 & 1 \\

\end{array}\right ]=\left [ \begin{array}{cc}

1/2 & 0 \\

0 & 1/3 \\

\end{array}\right ].](local/cache-TeX/ec79c008216e67d6d818b64df4eff879.png)